window安装、配置CUDA、cuDNN、TensorFlow-GPU

主要参考:https://blog.csdn.net/csdnfala/article/details/91358622https://blog.csdn.net/qq_32728345/article/details/81570504安装tf-gpu会自动替换tfcpu版本,本人环境自带vs2012、vs2015,安装的tf-gpu要求vs2017但本人没有安装,似乎集成在C...

主要参考:https://blog.csdn.net/csdnfala/article/details/91358622

https://blog.csdn.net/qq_32728345/article/details/81570504

安装tf-gpu会自动替换tf cpu版本,

本人环境自带vs2012、vs2015,安装的tf-gpu要求vs2017但本人没有安装,似乎集成在CUDA、cuDNN安装包中

1 确定并下载对应版本的CUDA

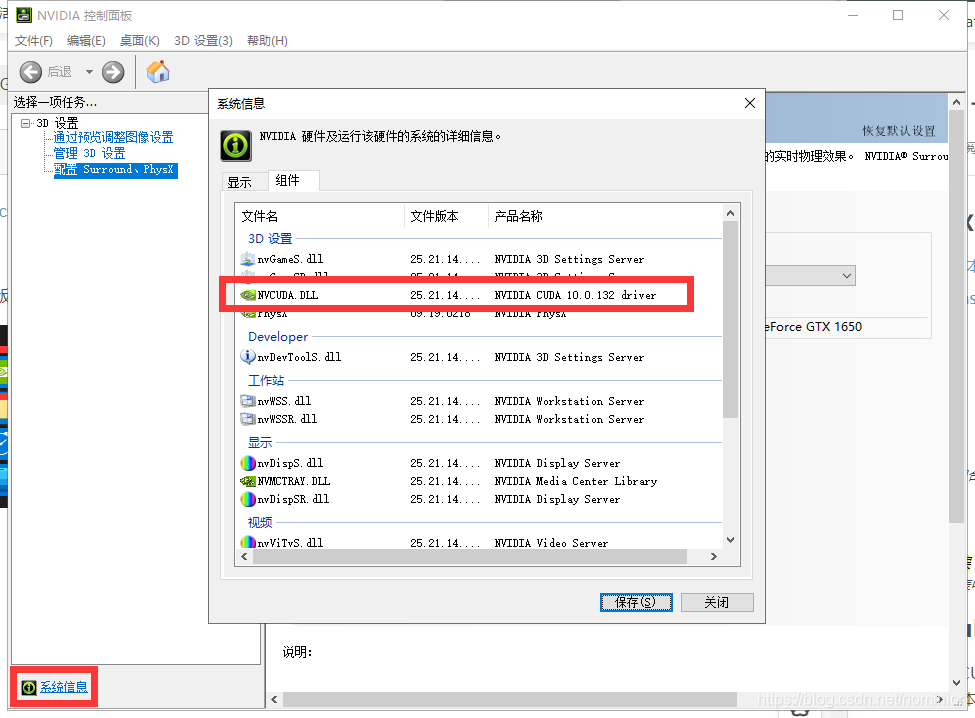

打开nvidia控制面板 ,win10在系统信息-组件-NVCUDA.DLL中查看,本人最高支持版本为10.0.132,下载对应CUDA:https://developer.nvidia.com/cuda-toolkit-archive

,win10在系统信息-组件-NVCUDA.DLL中查看,本人最高支持版本为10.0.132,下载对应CUDA:https://developer.nvidia.com/cuda-toolkit-archive

2 确定并下载对应版本cuDNN、TensorFlow-gpu

选择对应版本的cuDNN:https://developer.nvidia.com/rdp/cudnn-archive

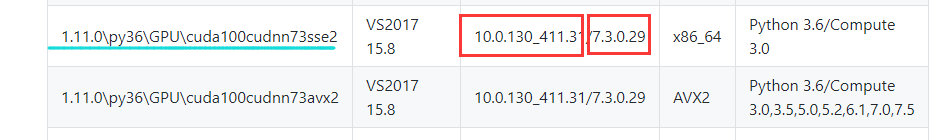

一个CUDA可以安装不同版本cuDNN,选择时,应根据提供的TensorFlow对应,在readme中查看:https://github.com/fo40225/tensorflow-windows-wheel

本人选择版本为python3.6、cuda10.0、cuDNN7.3、sse版本

3 安装CUDA、cuDNN、tf-gpu

安装CUDA,如果不修改安装路径,默认解压到电脑用户的temp文件夹下,并安装到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v10.0

解压cuDNN,将压缩包内文件依次复制到安装路径下

讲sse版本的tf-gpu.wheel的两个压缩包一起解压,得到一个wheel,在cmd中使用“pip install wheel绝对路径”进行安装tf

使用如下代码验证是否安装成功

import tensorflow as tf

hello =tf.constant("hello,tf")

sess = tf.Session()

print(sess.run(hello))gpu操作

# 查看gpu名称

print(tf.test.gpu_device_name())

# 查看gpu是否可用

print(tf.test.is_gpu_available())

# 查看所有设施

print(device_lib.list_local_devices())

# 设置按需增长

config = tf.ConfigProto()

config.gpu_options.allow_growth=True

sess = tf.Session(config=config)

# keras配置

import keras.backend.tensorflow_backend as KTF

KTF.set_session(sess)

欢迎来到由智源人工智能研究院发起的Triton中文社区,这里是一个汇聚了AI开发者、数据科学家、机器学习爱好者以及业界专家的活力平台。我们致力于成为业内领先的Triton技术交流与应用分享的殿堂,为推动人工智能技术的普及与深化应用贡献力量。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)