Linux x86_64 GA102 [GeForce RTX 3090]**安装pytorch-gpu,显卡驱动,cuda,cudnn

Linux x86_64 GA102 [GeForce RTX 3090]**安装pytorch-gpu,显卡驱动,cuda,cudnn按照上面的代码安装对应的torch,即使更换镜像源依然失败了然后只能去下载离线包,找到对应版本的torch和torchvision:离线包下载地址https://download.pytorch.org/whl/torch_stable.html之后pip安装即可

Linux x86_64 GA102 [GeForce RTX 3090]**安装pytorch-gpu,显卡驱动,cuda,cudnn

# ROCM 5.1.1 (Linux only)

pip install torch==1.12.1+rocm5.1.1 torchvision==0.13.1+rocm5.1.1 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/rocm5.1.1

# CUDA 11.6

pip install torch==1.12.1+cu116 torchvision==0.13.1+cu116 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu116

# CUDA 11.3

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

# CUDA 10.2

pip install torch==1.12.1+cu102 torchvision==0.13.1+cu102 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu102

# CPU only

pip install torch==1.12.1+cpu torchvision==0.13.1+cpu torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cpu按照上面的代码安装对应的torch,即使更换镜像源依然失败了

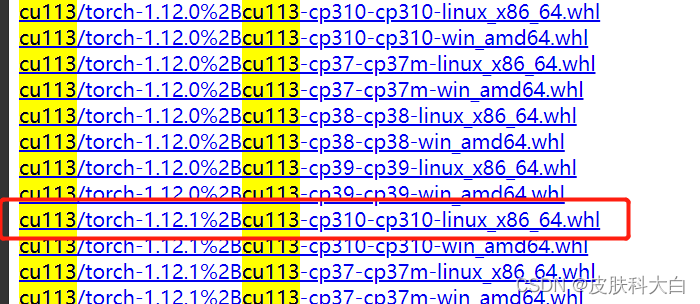

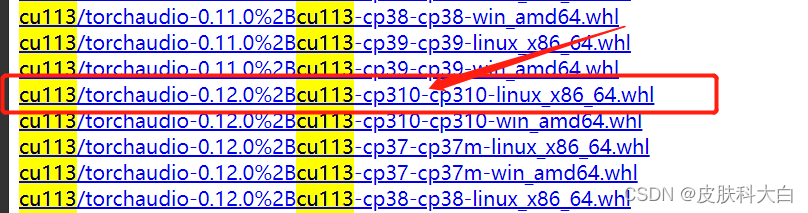

然后只能去下载离线包,找到对应版本的torch和torchvision:

离线包下载地址 https://download.pytorch.org/whl/torch_stable.html

https://download.pytorch.org/whl/torch_stable.html

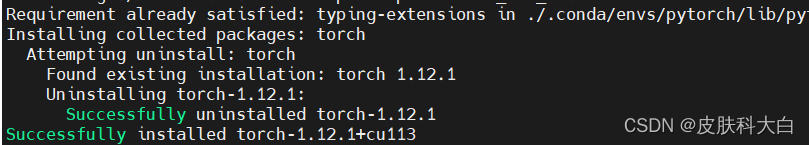

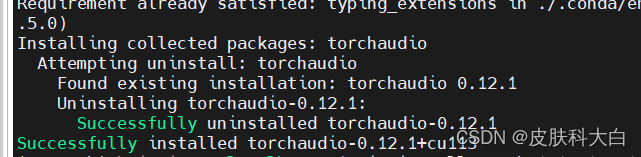

之后pip安装即可:

pip install torch-1.8.0+cu111-cp38-cp38-linux_x86_64.whl

pip install torchvision-0.9.0+cu111-cp38-cp38-linux_x86_64.whl

此处需要提醒一点,若是安装的cuda版本高于torch支持(比方说笔者这里,cuda版本是11.4,但是安装的torch1.8.0只支持最高11.1).一般来说安装之后问题不是很大,只要差的版本不是很大就行。但最好还是一致。 详见:本机cuda版本可以高于安装pytorch时的cuda版本吗?

之后可以安装一些其他依赖,pandas,json,etc.有关于TensorFlow GPU版本,还有类似于Keras,这里不做介绍。

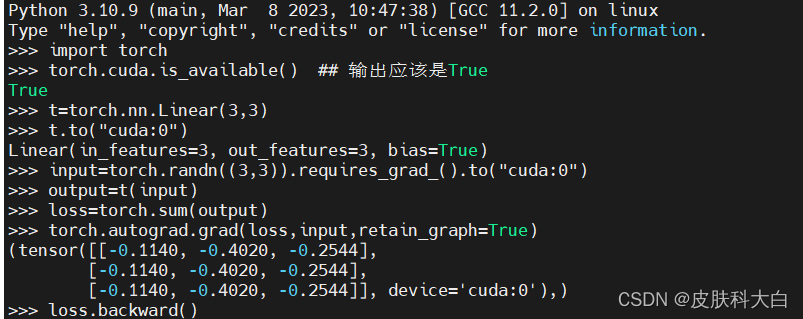

7. 验证

最后验证一下是否安装成功,terminal里进入python环境,然后执行以下代码:

import torch

torch.cuda.is_available() ## 输出应该是True

t=torch.nn.Linear(3,3)

t.to("cuda:0")

input=torch.randn((3,3)).requires_grad_().to("cuda:0")

output=t(input)

loss=torch.sum(output)

torch.autograd.grad(loss,input,retain_graph=True) ## 输出应该是一个gpu上的梯度矩阵

loss.backward()

没有报错则算成功,说明可以使用gpu进行推理反传

如果你还没成功,私信我

欢迎来到由智源人工智能研究院发起的Triton中文社区,这里是一个汇聚了AI开发者、数据科学家、机器学习爱好者以及业界专家的活力平台。我们致力于成为业内领先的Triton技术交流与应用分享的殿堂,为推动人工智能技术的普及与深化应用贡献力量。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)