cuda out of memory后清理GPU缓存

输入nvidia-smi查看GPU利用率发现,整体GPU占用了9000M/10000M,但下面运行的进程却不到2000M。事情是这样的,明明模型就不大,但是一直报错cuda out of memory.把所有占用GPU的进程都清理掉就行了。

·

省流:

sudo fuser -v /dev/nvidia* |awk ‘{for(i=1;i<=NF;i++)print "kill -9 " $i;}’ | sudo sh

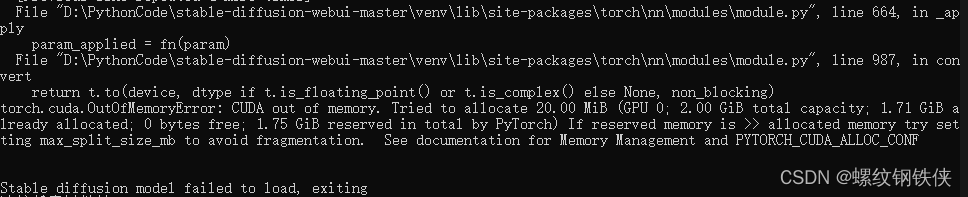

事情是这样的,明明模型就不大,但是一直报错cuda out of memory.

输入nvidia-smi查看GPU利用率发现,整体GPU占用了9000M/10000M,但下面运行的进程却不到2000M。

实在查不到哪些僵尸进程占用GPU的话,直接用这个命令:

sudo fuser -v /dev/nvidia* |awk '{for(i=1;i<=NF;i++)print "kill -9 " $i;}' | sudo sh

把所有占用GPU的进程都清理掉就行了

欢迎来到由智源人工智能研究院发起的Triton中文社区,这里是一个汇聚了AI开发者、数据科学家、机器学习爱好者以及业界专家的活力平台。我们致力于成为业内领先的Triton技术交流与应用分享的殿堂,为推动人工智能技术的普及与深化应用贡献力量。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)